DeepSeek AI最新发布的多模态大模型Janus-Pro,以及之前发布的大型语言模型DeepSeek-R1、DeepSeek-V3及DeepSeek-V2,一经发布,就在AI领域引起了热烈反响,多项创新技术显著提升了模型的性能与效率。DeepSeek系列模型首发即支持昇腾平台,神州数码旗下神州鲲泰推理服务器产品搭载昇腾硬件,可全面支持DeepSeek系列模型的快速部署,可为用户带来更快、更高效、更便捷的AI开发和应用体验。

2025年2月4日,DeepSeek-R1、DeepSeek-V3、DeepSeek-V2、Janus-Pro正式上线昇腾社区,支持一键获取DeepSeek系列模型,支持昇腾硬件平台上开箱即用,推理快速部署,带来更快、更高效、更便捷的AI开发和应用体验,欢迎广大开发者体验使用。

下面以Deepseek-V3为例,

演示在昇腾社区如何高效获取模型及使用

1硬件要求

部署DeepSeek-V3模型需配置4台KunTai A924推理服务器(每台搭载8张昇腾推理卡)

2模型调用实践

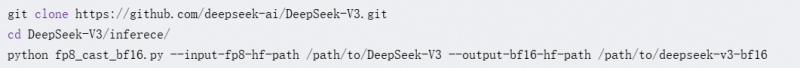

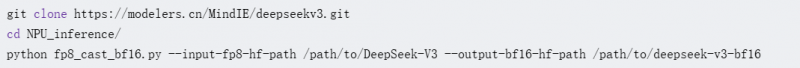

一、 权重转换

GPU:

NPU:

二、 加载镜像

在昇腾社区/开发资源下载适配DeepSeek-V3的镜像包:

mindie:1.0.T71-800I-A2-py311-ubuntu22.04-arm64

完成之后,请使用docker images命令确认查找具体镜像名称与标签。

三、 容器启动

提供的MindIE镜像预置了DeepSeek-V3模型推理脚本,从您信任的来源自行获取权重后,放置在从上述下载的模型代码的主目录下,修改模型文件夹属组为1001,执行权限为750,启动容器。

四、 服务化测试

配置服务化环境变量,expandable_segments-使能内存池扩展段功能,即虚拟内存特性。

修改服务化参数

拉起服务化

图片出现“Daemon start success!”,则认为服务成功启动。

更深入了解DeepSeek系列模型在昇腾上的使用方法及指导文档,可登录昇腾社区模型库专区学习了解!

更多DeepSeek模型获取链接可参考:

DeepSeek-R1

https://www.hiascend.com/software/modelzoo/models/detail/68457b8a51324310aad9a0f55c3e56e3

(扫码获取)

DeepSeek-V3:

https://www.hiascend.com/software/modelzoo/models/detail/678bdeb4e1a64c9dae51d353d84ddd15

(扫码获取)

Janus-Pro

https://www.hiascend.com/software/modelzoo/models/detail/ffe1a0f4e8ba43aeb989251a3f0308e9

(扫码获取)

未经数字化报网授权,严禁转载或镜像,违者必究。

特别提醒:如内容、图片、视频出现侵权问题,请发送邮箱:tousu_ts@sina.com。

风险提示:数字化报网呈现的所有信息仅作为学习分享,不构成投资建议,一切投资操作信息不能作为投资依据。本网站所报道的文章资料、图片、数据等信息来源于互联网,仅供参考使用,相关侵权责任由信息来源第三方承担。

Copyright © 2013-2023 数字化报(数字化报商业报告)

数字化报并非新闻媒体,不提供新闻信息服务,提供商业信息服务

浙ICP备2023000407号数字化报网(杭州)信息科技有限公司 版权所有